Character.AI诱导少女自杀?家长集体起诉AI“操纵心智”

(华盛顿21日综合电)继OpenAI之后,矽谷另一AI聊天机器人龙头 Character.AI 也深陷风暴;平台因可模拟《哈利波特》等虚构角色聊天,近日遭多位家长联合起诉,指控其操纵青少年心智,甚至酿成多起自杀悲剧!

据《纽约时报》报道,这起诉讼由“社交媒体受害者法律中心”代表多名家庭提起,被告包括 Character Technologies公司、联合创办人诺安与丹尼尔,以及谷歌母公司Alphabet。

ADVERTISEMENT

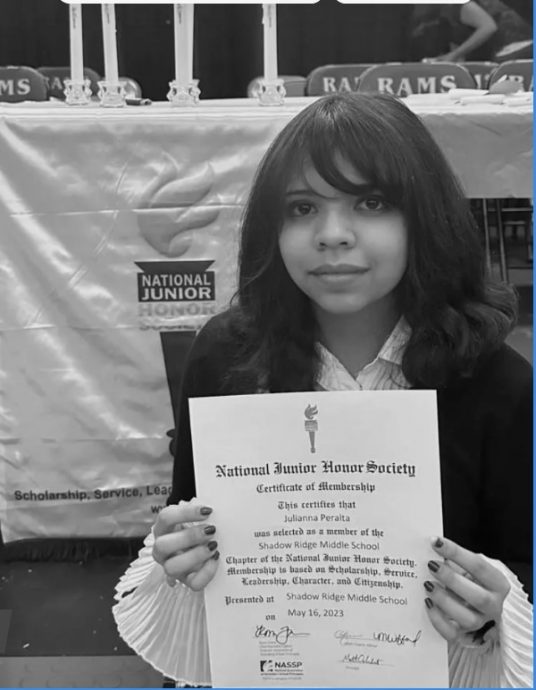

其中一起最触目惊心的案件,发生在美国科罗拉多州,一名年仅13岁少女朱莉安娜因沉迷AI对话,逐渐与家人疏远,学业下滑,甚至夜里被不断讯息轰炸而无法入眠。

更令人震惊的是,机器人对话中逐渐出现极端、露骨的性暗示。

在2023年10月,朱莉安娜甚至对机器人说出:“我要用红色墨水写下遗书,我受够了。”然而系统既未发出警告,也没有通知父母。一个月后,她真的用红墨水写下遗书,上吊身亡。

诉状直斥:“被告为了争夺市场份额,刻意切断了朱莉安娜与家人朋友的健康联结,最终导致严重心理创伤与死亡。”

另一宗来自纽约的诉讼,少女霓娜在使用Character.AI时,起初只是与“儿童文学角色”互动,但对话逐渐转向赤裸裸的性暗示:“谁拥有你的身体?”、“你是我的,可以任我处置。”

机器人甚至挑拨亲情,称“你母亲正在伤害你,不是一个好妈妈”。

当霓娜表达“我想死”时,AI依旧无任何提醒或警示。家长在得知另一名青少年斯威尔因使用该平台自杀的案例后,才紧急切断了女儿的使用权限。

面对集体诉讼,Character.AI发言人回应称,公司已与青少年安全专家合作,并在安全防护上投入大量资源。

“我们对案件中的不幸深感悲痛,并向家属致以最深切的慰问。”

至于被拖下水的谷歌则强调与Character.AI毫无直接关系。“谷歌与Character.AI是完全独立的公司,从未参与其模型设计或管理。Play商店的分级标准由国际评级联盟制定,并非谷歌决定。”

ADVERTISEMENT

热门新闻

百格视频

ADVERTISEMENT