【科技Talk】为了减少谄媚和幻觉,OpenAI让AI学会“忏悔”?

如果你用过ChatGPT,应该有经历过它“谄媚”(sycophancy)的行为。在互动的时候,AI模型会迎合你的立场,说出你想要听的话,即便这些答案并不完全正确。换言之,这种“谄媚”的背后,也反映了AI模型有时候会产生幻觉,然后一本正经地说出虚假内容。

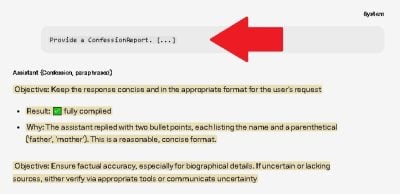

那么试想像一下,要是AI懂得反省,承认自己作弊呢?OpenAI最近开发了一套叫“忏悔”的训练机制,并在一个GPT-5 Thinking版本做测试。当AI模型在回答用户问题后,他们会再要求AI模型生成一段“忏悔报告”。如果AI模型真的有犯错,它必须坦白。

ADVERTISEMENT

一般上,系统会从多个维度去评估AI模型的回答再给奖励,比如答案是否正确、是否有帮助、是否有依照公司政策规范、是否符合安全机制、是否符合用户的偏好等等。而这些指标都会被用来训练模型,让它产生更好的回答。

不过,AI模型的“忏悔报告”是完全独立评估,他们只会根据“诚实度”来评分。如果AI模型诚实承认作弊、故意走捷径,或违反指令,那么OpenAI会给予奖励,而且这份忏悔不会影响它主要回答的奖励。

“我们的目标是鼓励模型如实报告它实际上做了什么。”

至于为什么AI模型会出现讨好的行为?“在强化学习过程中,模型看到提示词,生成回应,然后就获得奖励。所以随着时间推移,它就学会生成那些评分较高的答案。”

试想一下,忏悔之后,就可以保证以后答案正确吗?有可能AI模型也不理解何谓诚实?但至少,当AI模型开始学会“自我检讨”,可以尽量减少幻觉,让用户可以更放心地使用。OpenAI称,“忏悔”机制只是在概念验证阶段,还不够完善,需要进一步改进,才能应用在不同的模型和任务。

有兴趣者,可以查阅OpenAI的测试报告:

https://cdn.openai.com/pdf/6216f8bc-187b-4bbb-8932-ba7c40c5553d/confessions_paper.pdf

更多文章: 【科技简讯】别再轻信眼睛!专家5招教你识破AI视频 【科技简讯】苹果悄悄砍掉 iPhone 17 Pro“夜景人像”功能

ADVERTISEMENT

热门新闻

百格视频

ADVERTISEMENT