【科技Talk】AI很“吃电” 年耗电量=小国年用电量

报道:本刊 林德成

照片:法新社

ADVERTISEMENT

ChatGPT强势崛起引发了一连串效应,全球人工智能(AI)发展开始狂飙,科技巨头投入大量资源开发大语言模型(LLM)和聊天机器人,抢占AI市场份额,比方说Meta的Llama 2、谷歌的PaLM 2和Bard、百度的文心一言等等。

除了AI聊天机器人,市场上亦出现很多生成式AI产品,像Midjourney﹑Stable Diffusion、Musicfy和MusicLM诸如此类。网民只需输入文字指令,AI平台便会自动生成图像、文字、音乐和视频,从而令到互联网被AI“污染”,充斥着各种真假难辨的内容。

这场科技革命有利必有弊,虽然改写人类社会的发展,但也在自然环境埋下无法预估的祸害,因为这些大语言模型比你想像中更耗水和耗电。每次研发新一代的大语言模型,参数会达到上千亿,需要动用很多图形处理器(GPU)来提升AI算力。当你提升伺服器性能和算力,自然会消耗更多能源。

AI伺服器耗电量超乎想像

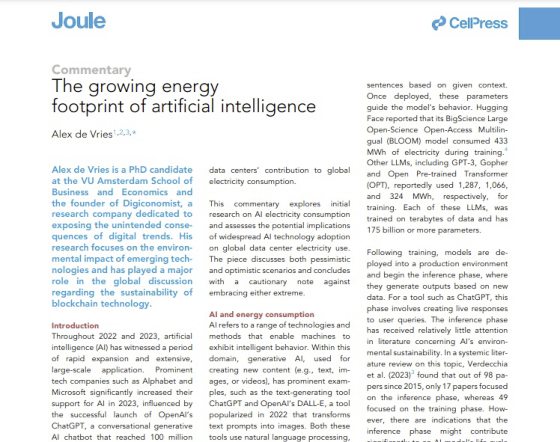

近期,阿姆斯特丹自由大学商学与经济学院的一名博士生Alex de Vries在《Joule》学术刊物发布了一份报告。他透露,如果AI产业继续增长,到了2027年,全球AI伺服器所消耗的电量会等于荷兰一年的用电量。

根据报告,从2010年到2018年,全球数据中心的耗电量只是增长了6%。如果科技公司持续开发和维护AI模型和应用,将会令到数据中心的耗电量不断攀升。

在AI浪潮中,GPU是最稀缺的资源。科技公司若想要训练大语言模型,需要大量的GPU来维持AI运行。NVIDIA作为GPU市场的龙头,拥有90%的市占率,而NVIDIA的旗舰GPU产品“A100”和“H100”就成了抢手货。

Alex de Vries想要厘清AI伺服器到底消耗多少电力。可是科技公司没有透露这方面的数据,他便以AI伺服器的销售额来推算。英国《金融时报》曾报道,NVIDIA计划在2024年推出150万至200万个“H100”。他估算,如果NVIDIA每年的出货量能达到150万个AI处理器,那么到了2027年,AI产业每年会消耗大约85至134太瓦时(TWh)的电量,而这个耗电量相当于一个小国的全年用电量,占全球用电量的0.5%。

“你就会在谈着像荷兰这样的国家电力消耗规模。(然后)你在谈着我们全球总用电量的0.5%。”他在BBC的采访中如此说道。

ChatGPT一年排放8.4吨二氧化碳

那么ChatGPT每天会消耗多少电量?报告里面指出,训练GPT-3模型时,需要用到1287兆瓦时(MWh)的电量。如果OpenAI要让ChatGPT正常操作,每一天会消耗564兆瓦时的电量。这意味着AI系统在推理时,会动用更多能源。此外,谷歌报告称,从2019年到2021年,与AI相关的能源消耗里面,有60%是来自生成推理的阶段。

Alex de Vries引述研究公司SemiAnalysis的资料,如果在谷歌搜索加插类似ChatGPT的生成式AI功能,谷歌需要51万2821个NVIDIA HGX A100伺服器(总共410万2568个GPU),预计每天会消耗80亿瓦时(GWh)的电量,一年累积下来会达到29.2太瓦时(TWh)。按照这个假设,谷歌AI伺服器的耗电量就会等于爱尔兰一年的用电量(每年29.3太瓦时)。

当然,在推高AI伺服器的性能时,间接也在制造更多的碳排放量。根据Earth.Org网站计算,一个人平均每年排放4吨的二氧化碳,而ChatGPT的排放量是一年8.4吨。

那么,你知不知道,当你向ChatGPT输入5至50个问题或指令时,ChatGPT是需要消耗500毫升的水。每当AI数据中心在高速运转时,科技公司会准备冷却塔来为伺服器降温,避免这些AI伺服器过热。

有资料显示,科技公司会把伺服器的温度控制在摄氏10度至27度之间。然后伺服器每消耗一度电(千瓦时,KWh),需要“喝”下一加仑(3.8公升)的水。以GPT-3为例,每一次训练GPT-3模型,需要耗费70万公升的淡水。而这个水量可以用来生产370辆BMW汽车或320辆的特斯拉电动车。可想而知,GPT-4或以上的模型将会更耗水电。倘若未来全面AI,政府和科技公司能够承担昂贵的运作成本吗?

对此,他希望开发者不要只专注在优化AI功能,反而要思考是否每一个应用程式都要用到AI。

相关稿件: 【科技Talk】ChatGPT大红OpenAI却严重缺钱 4大关卡阻发展 【科技简讯】ChatGPT大热是吹的?使用率仅19%

ADVERTISEMENT

热门新闻

百格视频

ADVERTISEMENT